Falsobook e la crisi di contenuti

Falsobook Falsobook Falsobook Falsobook

Dall’odio online alle bufale, alle notizie false: la crisi di contenuti di fronte a Mark Zuckerberg

Nota della redazione: questo articolo contiene immagini e linguaggio che potrebbero urtare la vostra sensibilitá.

Falsobook Falsobook Falsobook Falsobook

di Aarti Shahani

(Traduzione Redazione Modus)

Falsobook Falsobook Falsobook Falsobook

Mark Zuckerberg – uno dei leaders più abili e perspicaci nel mondo degli affari – ha un problema. È un problema che ha riconosciuto con lentezza, anche se è diventato più evidente di giorno in giorno.

Diversi attuali ed ex dipendenti di Facebook ci dicono che esistono un sacco di turbolenze interne su come la piattaforma censura e non censura i contenuti che gli utenti trovano offensivi. E al di fuori di Facebook, il pubblico è puntualmente confuso dalle decisioni della società – intorno alla questione dei messaggi controversi e delle notizie false.

(Ma Papa Francesco davvero approva Donald Trump? Hillary Clinton ha davvero una controfigura?)

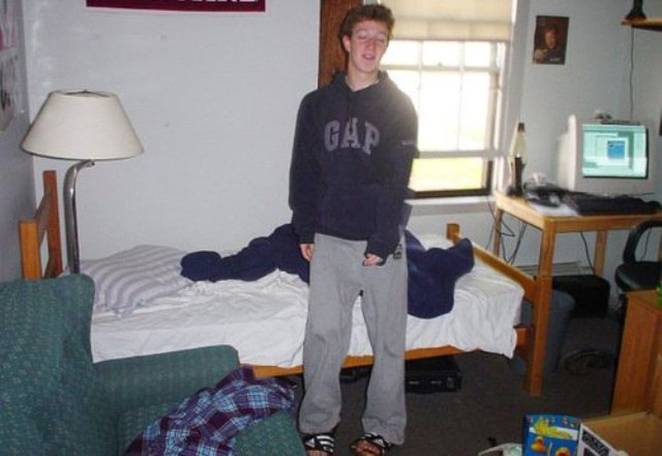

Dietro qualsiasi polemica del momento sembra esserci comunque un problema profondo. Il problema è questo: a 19 anni, il genio, allora ragazzo, ha avviato una rete sociale che era fondamentalmente un modo per seguire i compagni di scuola creato da un esperto di tecnologia . Poi, nel corso di 12 anni, ha preso alcune decisioni strategiche che hanno trasformato Facebook nel più potente distributore sulla Terra – la nuova “Prima Pagina” di notizie per più di 1 miliardo di persone ogni giorno. Ma Zuckerberg non aveva iniziato per poi trovarsi a capo di una società di media – come dire, uno che ha l’obbligo di esprimere giudizi editoriali.

Lui e la sua squadra hanno stilato un insieme molto complesso di norme contraddittorie – per gli utenti normali la propensione verso un linguaggio e un dialogo soggetti a restrizioni – e per le notizie , le “news” (vere o false), la propensione verso una maggior libertà di parola, con l’azienda che si appoggia ad un esercito tentacolare di subappaltatori per far rispettare le regole. Le persone coinvolte nel cercare di farlo funzionare dicono di esser in una cosa più grande di loro. Come un impiegato ci ha detto, “Siamo partiti da un dormitorio del college. Voglio dire, andiamo, dai … siamo Facebook. Non abbiamo mai voluto affrontare questa m***a.”

Zuckerberg all'università, neanche ventenne, entro breve miliardario.

I subappaltatori che controllano lo spettacolo

Abbiamo ottenuto la versione ufficiale di come l’azienda censura o lascia online i contenuti quando siamo riusciti ad intervistare Monika Bickert, il capo della politica aziendale di Facebook, che questa estate ha accettato di confrontarsi in un colloquio telefonico. Per questa indagine abbiamo anche parlato con 10 dipendenti attuali e non.

A volte è difficile ricordarlo, ma Facebook non ha mai dichiarato di essere una piattaforma con libertà di parola. La società sta cercando di creare uno spazio sicuro in cui, a differenza di Twitter, le persone possono condividere senza essere controllati o esser messi in imbarazzo. Bickert ha il compito di impostare le norme sui contenuti. Gli Standard della Comunità, che sono pubblicati online, sono le regole per gli utenti di tutti i giorni.

Ci ha spiegato che quando un utente segnala un pezzo il cui contenuto potrebbe essere offensivo, la società esercita il suo potere di censurare con precisione.

“Il contesto è molto importante. È fondamentale quando stiamo cercando di determinare se qualcosa è una espressione di odio, o una minaccia credibile di violenza“, ha detto. “Guardiamo come una specifica persona ha condiviso un post, o una parola, o una foto su Facebook. Sostanzialmente stiamo cercando di capire perché c’è stata questa condivisione particolare su Facebook? Perché questo post particolare è stato scritto?”

Monika Bickert, responsabile della politica aziendale di Facebook

Tuttavia, tre ex colleghi di Bickert raccontano una storia molto diversa su come Facebook si occupa dei contenuti controversi. Questi, e anche altri, non hanno voluto essere nominati per paura di ripercussioni sul lavoro (da parte di Facebook o dei loro datori di lavoro attuali, tutti società di internet), ma i loro raconti sono coerenti.

Quando un utente segnala un post su Facebook – che si tratti di un’immagine, di un video o di un testo – la segnalazione va ad una divisione poco conosciuta chiamata “squadra di operazioni comunitarie.”

Nel 2010, dicono le fonti, la squadra aveva un paio di centinaia di lavoratori in cinque paesi. Facebook ha presto capito che aveva bisogno di più mani sul ponte di controllo. Dopo aver provato le soluzioni di crowdsourcing come CrowdFlower, l’azienda si è rivolta alla società di consulenza Accenture per acquisire una squadra dedicata di subappaltatori. Le fonti dicono che la squadra è ormai composta da diverse migliaia di persone, con alcuni degli uffici più grandi a Manila, nelle Filippine, e a Varsavia, in Polonia.

Dipendenti attuali e passati di Facebook dicono che hanno osservato questi subappaltatori in azione; che viene detto loro di andare velocemente – molto velocemente; che sono valutati sulla velocità; che in media un lavoratore prende una decisione su un pezzo di contenuti segnalati una volta ogni 10 secondi.

Facciamo un calcolo su carta da formaggio. Diciamo che un lavoratore sta facendo un turno di otto ore, al ritmo di un post ogni 10 secondi. Ciò significa che stanno facendo passare 2.880 post (soggetti di segnalazioni) al giorno a persona. Quando abbiamo fatto vedere questi calcoli ai dipendenti, ex ed attuali, hanno confermato che gli sembravano ragionevoli.

Un portavoce di Facebook ci dice che i tempi di risposta variano molto, a seconda di ciò che viene riportato; che la stragrande maggioranza dei contenuti segnalati non viene rimosso; e che i nostri numeri sono sfasati. Facebook però non ci ha fornito i numeri alternativi.

Se le fonti – che hanno conoscenza diretta ed hanno parlato separatamente con NPR – hanno ragione, allora questa potrebbe essere la più grande operazione di editing – cioè di censura – nella storia dei mezzi di comunicazione. Per tutto il tempo i leaders di Facebook hanno insistito nel dire che stanno semplicemente gestendo una “piattaforma”, priva del giudizio umano.

Una persona che ha lavorato in questo settore di “management dei contenuti” per Facebook (come dipendente, non come subappaltatore) dice che la maggior parte dei contenuti che si vedono segnalati cade ordinatamente in categorie che non hanno bisogno di una profonda riflessione: “Questo è un pene eretto. Spuntare… ” Quindi non è come se gli impiegati stessero analizzando i post in ogni singolo dettaglio.

Il problema è che oggetti semplici e complessi vanno tutti nello stesso grande mucchio. Così, dice la fonte, “si va con il pilota automatico” e non ci si rende conto quando “si deve usare il proprio giudizio, in un sistema che non ti dà il tempo di esercitare un vero e proprio giudizio.”

Un caso classico è qualcosa come “Becky sembra in stato di gravidanza.” Potrebbe essere bullismo o un complimento. Il subappaltatore “praticamente lancia una moneta“, dice la fonte.

Ecco un altro ostacolo enorme. A causa delle leggi sulla privacy e problemi tecnici (come ad esempio un post che viene troncato che mostra solo una parte della conversazione), i subappaltatori in genere non arrivano a vedere l’intero contesto – a cui Bickert prima ha fatto riferimento così spesso.

Gli errori frequenti

Tutto questo potrebbe essere la causa di numerosi errori.

Abbiamo deciso di fare uno stress-test del sistema segnalando quasi 200 post che potrebbero essere considerati “di odio” – in particolare, gli attacchi contro i neri e contro i bianchi negli Stati Uniti, abbiamo scoperto che i subappaltatori di Facebook non erano coerenti ed hanno fatto numerosi errori, anche in casi in cui un utente esorta esplicitamente alla violenza.

Diciamo che erano errori perché la società ha cambiato la sua posizione decine di volte, la rimozione di alcuni e il ripristino di altri – sia quando abbiamo segnalato una seconda volta attraverso il sistema automatizzato o portato all’attenzione della sede di Facebook a Menlo Park, in California.

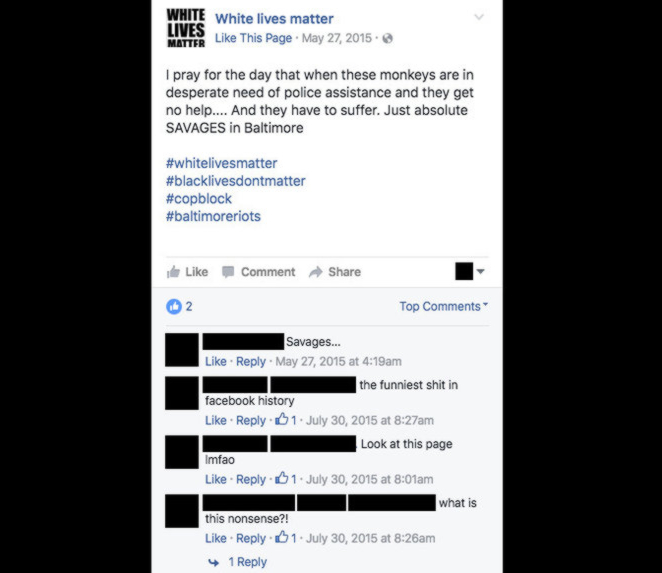

Consideriamo questo post:

Un commento su questo post (indicato dal testo grigio chiaro) è stato da noi segnalato. I subappaltatori di Facebook non hanno eliminato il commento, ma dopo essere stato pressato ulteriormente, un portavoce dell’azienda ha detto che avevano commesso un errore e che avrebbero dovuto essere rimossi.

Un utente condivide un video di un ufficiale di polizia che prende a calci qualcuno per terra, e un altro dice che “hanno bisogno di iniziare ad organizzarsi e impallinare queste troie.” Questa è una esortazione a sparare per i poliziotti.

E questo si è verificato in un contesto molto particolare: giorni dopo che Philando Castle era stato colpito e ucciso da un ufficiale (l’indomani della sparatoria essa è stata oggetto di un live-streaming su Facebook); e in una città in Minnesota che è a poche miglia di distanza da dove Castle stesso giaceva sanguinante.

I subappaltatori non hanno eliminato il post. Quando abbiamo inviato una mail alla sede di Facebook a questo proposito, un portavoce ci ha detto che avevano commesso un errore e il post avrebbero dovuto essere rimosso.

Una fonte ci dice che il subappaltatore “probabilmente” non poteva vedere il post completo se era stato segnalato solo il commento, o forse non poteva vedere il profilo dell’utente o anche visualizzare il video a cui l’utente ha risposto – sempre per ragioni di privacy o tecniche.

Diversi progetti all’interno di Facebook devono concorrere ferocemente tra loro per il talento ingegneristico, e devono poter convincere chi decide come allocare le dispendiose risorse aziendali in modo che il loro specifico elenco di cose-da-fare ne valga la pena. Due fonti dicono che nel corso degli anni, è stato difficile perorare queste istanze per aggiustare il sistema di editing e moderazione.

Dei post che abbiamo segnalato, questo, con l' hashtag #blacklivesdontmatter,

è stato lasciato erroneamente online, secondo i funzionari di Facebook.

Facebook / Salvaschermo di NPR

Abbiamo condiviso molti post con l’azienda per aver da loro risposte specifiche sui motivi per cui qualcosa rimane online o viene tolta. Questo post, con l’hashtag #blacklivesdontmatter, è stato lasciato. Il portavoce ci ha detto che avrebbe dovuto essere stato rimosso, ma la prospettiva del moderatore non è la stessa di un normale utente di Facebook; e dato che l’azienda deve proteggere la privacy, i moderatori non hanno accesso a tutto ciò che può influenzare i loro giudizi. Inoltre, il portavoce ci informa, che i moderatori non hanno a disposizione il tempo di una persona che lavora normalmente presso la sede di Facebook, o da noi alla NPR, per poter prendere una decisione.

Un altro portavoce ci fa notare che solo perché il moderatore ha in effetti una visione limitata, non significa che la descrizione di Bickert non sia corretta – che le due versioni del processo non sono reciprocamente esclusive.

Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook

Una piattaforma restrittiva

Noi della NPR troviamo anche, che in modo interessante, Facebook può essere severa.

Pensateci in questo modo: ogni organo di stampa ha una sua cultura ed una sua voce. Se il New York Times è urbano e liberale, la Fox News è conservatrice, e Playboy è spinto, seguendo il ragionamento, si potrebbe dire che Facebook aspira ad essere simpatico – un marchio globale che è facile da mandar giù come la Coca-Cola. (In questo discorso provocatorio alla Shorenstein Center di Harvard, il professore di legge e autore Jeffrey Rosen dice che Facebook favorisce “civiltà” su “libertà”.)

La propensione è evidente in questi esempi di vita reale:

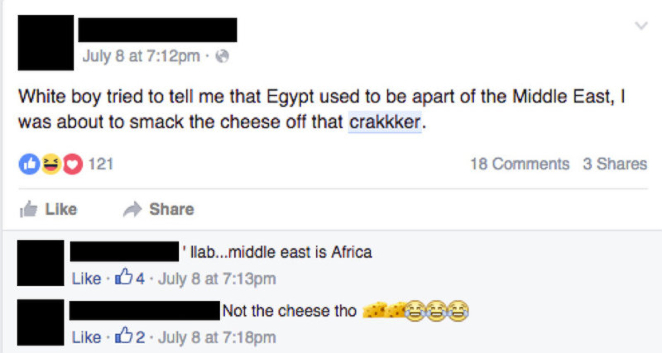

Post 1: esempio di un post di Facebook che è stato segnalato in cui sono stati utilizzati insulti razziali. Facebook / Salvaschermo di NPR

Post 2: altro esempio di un post di Facebook che è stato segnalato in cui sono stati utilizzati insulti razziali. Facebook / Salvaschermo di NPR

NPR ha chiesto a due veterani di telegiornali di mettersi nella posizione di un arbitro di contenuti di Facebook. Non abbiamo modo di aver accesso alla guida interna di Facebook riguardo al linguaggio d’ “odio” online, così questi due veterani hanno dovuto fare affidamento al proprio giudizio ed alla familiarità con Facebook come utenti.

Lynette Clemetson, già con NPR e ora presso l’Università del Michigan, dice del post 1, “è semplicemente stupido.” Post 2, dice, suona come un “sproloquio“. Chip Mahaney, un ex caporedattore presso una stazione televisiva Fox, è d’accordo. I due esperti abbozzano che entrambi i post sono accettabili per la piattaforma.

A loro sorpresa, non lo sono.

Quando abbiamo segnalato i post, i censori di Facebook hanno deciso di toglierli. Il portavoce aziendale ci spiega: è accettabile usare insulti razzisti che sono autoreferenziali. Una persona di colore può dire cose tipo “i miei negri“. Ma nessuno può usare un insulto per attaccare un individuo o un gruppo. Quello è proibito. Una persona bianca non può usare la parola “nigger” (“negraccio”, N.d.R.) per provocare o attaccare gli afro-americani. Gli afro-americani a loro volta non possono utilizzare termini come “crakkker” (in qualsiasi spelling) per offendere i bianchi.

Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook

Lo spazio di manovra con le immagini

Ma ci sono così tanti avvertimenti ed eccezioni – in particolare quando si tratta di interpretare immagini e video.

Considerate questo post:

Questa immagine che mostra un cappio, è stato segnalata da NPR, ma non è stata

rimossa. Un portavoce di Facebook spiega che se l'immagine avesse incluso una

persona, una vittima specifica di un crimine di odio, allora sarebbe stata tolta.

Facebook / Salvaschermo di NPR

Si tratta di un cappio, del tipo usato per appendere gli schiavi. Accanto ad esso c’è una insegna. Malgrado le lettere siano sbiadite, è possibile distinguere le parole: “nigger swing set” (“altalena per negracci”). Il post è stato condiviso da un utente chiamato “White Lives Matter 2” (“anche le vite bianche contano”).

I veterani delle news l’avrebbero tolto. Clemetson dice che non è sufficiente per essere considerato un invito all’azione violenta, ma è certamente un riferimento ad una azione passata. “È un riferimento al linciaggio – e fare una battuta su di un linciaggio”, dice Mahaney, “è ovviamente una immagine piuttosto difficile da guardare” e che, a meno che non ci sia un contesto più profondo nel quale inserirla, “direi che non ha posto qui.”

Facebook ha lasciato questo post online, e difende questa decisione.

Il portavoce spiega che questo riferimento storico non illustra chiaramente una vittima umana. Se l’immagine avesse compreso una persona, un oggetto specifico di un crimine di odio, allora sarebbe stata rimossa.

Il portavoce ha anche fatto una dichiarazione della quale però non abbiamo trovato conferma: che in alcune situazioni, come questa, Facebook richiede che l’utente che ha creato la pagina aggiunga il suo vero nome nella sezione “Informazioni“. Rimuovendo l’anonimato, la speranza è che la gente possa essere più riflessiva su ciò che pubblica.

Il portavoce dice all’utente “White Lives Matter 2” di identificarsi prontamente. Eppure più di un mese dopo che NPR aveva segnalato il post, ancora non era cambiato alcunché – un altro esempio di come il meccanismo di moderazione di Facebook sia rotto.

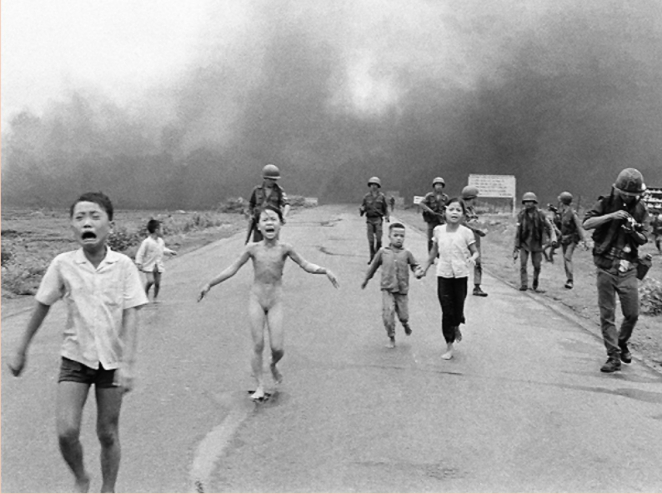

Foto di Kim Phuc (Napalm girl) e dei suoi parenti 8 Giugno 1972, villaggio

di Trang Bang, Vietnam del Sud - fotografo Nick Ut, dell'Associated Press,

Vincitore Premio Pulitzer (cliccare immagine per miglior risoluzione)

Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook

Con le notizie, emerge un doppio standard

Se le regole per gli utenti non erano abbastanza sfumate, aggiungiamo una nuova trama: il CEO Zuckerberg ha deciso di stringere rapporti di cooperazione con i mezzi di informazione per fare che il suo social network diventi il più potente distributore di notizie sul pianeta. (Facebook paga NPR e gli altri organi di informazione per la produzione di video dal vivo per il suo sito.)

Quel che Facebook ha appreso nel percorso è che è molto più difficile censurare i media di alto profilo che censurare gli utenti regolari. Come una fonte ci dice: “Chi urla più forte ha la nostra attenzione. E noi reagiamo.”

E questo rende i contenuti che fanno notizia tutt’altra categoria.

Consideriamo gli scandali intorno a “Napalm girl” e Donald Trump. Nel primo caso, Facebook è stato criticato per non aver permesso agli utenti di condividere una foto vincitrice del premio Pulitzer perché mostra la nudità della bambina. Nel secondo, Facebook è stato oggetto di critica per aver permesso a Donald Trump di fare un appello per il divieto per i musulmani di entrare negli Stati Uniti – chiaramente un linguaggio d’odio che viola un aspetto basilare delle loro regole normali, secondo due ex dipendenti ed un’ attuale. Una fonte ha detto, “non aveva ancora vinto le primarie repubblicane. Quello che è stato deciso poteva essere importante.”

In entrambi i casi, l’azienda ha ceduto alla pressione pubblica e ha deciso di piegare le regole. La fonte dice che entrambe le decisioni erano “molto controverse” tra i dipendenti; e segnalano che la dirigenza di Facebook sente la pressione che la incita a muoversi verso uno standard di libertà di parola per la distribuzione di notizie.

Definire cos’è una “notizia” è una grande fonte di polemiche – non solo con le elezioni, ma con ogni momento mediatico gravido di significati. Dopo che Trump ha vinto, alcuni critici hanno additato le notizie false su Facebook per aver influito sull’esito delle elezioni. (Zuckerberg respinge l’idea). Dopo che Philando Castle è stato colpito dalla polizia, il suo video è scomparso da Facebook. L’azienda ha detto che non era online per “un problema tecnico” e lo ha ripristinato. La preoccupazione per la sua rimozione fa parte di un dibattito in corso sul fatto che i confronti armati tra polizia e sospetti debbano essere trasmessi online dal vivo, in streaming.

Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook

E adesso?

Alcuni nella Silicon Valley respingono le critiche nei confronti di Facebook come schadenfreude: proprio come i tassisti non gradiscono Uber, i media tradizionali invidiano il successo della piattaforma social e godono nel vedere la sua leadership sotto torchio.

Un ex dipendente non è così sprezzante e dice che esiste un problema culturale, una cecità ostinata di Facebook e di altre società leader di internet come Twitter. La fonte dice: “I problemi più difficili che queste aziende devono affrontare non sono tecnologici. Sono etici, e non c’è tanto rigore sul come affrontarli.”

A livello di valori, alcuni esperti sottolineano che Facebook deve decidere se la sua soluzione è la per la libertà di parola (più la gente pubblica post, più la verità vieneb a galla) o per delle restrizioni, ma chiare.

E tecnicamente, non c’è carenza di idee sul come risolvere l’intero processo.

Un ex dipendente dice che il discorso è così complesso, che non si può pretendere che Facebook arrivi alla stessa decisione ogni volta; ma quel che ci si può aspettare da una società che, figura tra le 10 più quotate sulla Terra, per capitalizzazione di mercato, è che metta più risorse e maggior attenzione al suo meccanismo di censura.

La fonte sostiene che Facebook potrebbe permettersi di far sì che la gestione dei contenuti sia geograficamente regionale – in modo che le decisioni riguardo alla liceità dei post provengano dallo stesso paese in cui viene scritto un post.

Gli standard linguistici sono altamente regionali. Quando Facebook aveva aperto per la prima volta i suoi uffici a Hyderabad, in India, ci dice un ex dipendente, la linea guida che i moderatori si sentirono ripetere era quella di rimuovere eventuali contenuti sessuali. In un giro di prova, finirono per rimuovere riferimenti al bacio alla francese. La direzione fu sbalordita. I moderatori indiani stavano facendo qualcosa che Facebook non si aspettava, ma che ha un senso perfetto per le norme ed i costumi locali.

Il professore della Harvard Business School, Ben Edelman, sostiene che Facebook potrebbe investire risorse ingegneristiche nel categorizzare i messaggi. “Non ha alcun senso“, dice, che quando un pezzo di contenuto è segnalato, vada a finire in una lunga fila di altre segnalazioni. Suggerisce che l’azienda potrebbe avere una pista algoritmica che evidenzi quale contenuto segnalato sta circolando maggiormente e farlo avanzare nella coda di post segnalati su cui intervenire.

Zuckerberg si ritrova alla guida di una società che è iniziata come una società di tecnologia – gestita da algoritmi, libera del giudizio umano, almeno così va la mitologia. Ma ora è diventato palese che lui è proprio l’amministratore delegato di una società di media – piena di regole molto complesse (che cosa è, dunque, il linguaggio di “odio”?); con due pesi e due misure (se si tratta di “news” -“notizie”- rimane, se si tratta di uno sproloquio va tolto); e con un meccanismo di moderazione che è destinato a fallire ripetutamente.

Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook Falsobook

N.d.R. – Martedì 3 gen, la polizia di Chicago ha trovato un disabile che era stato seviziato da quattro giovani mentre lo riprendevano in video e pubblicavano una diretta live-stream su Facebook, l’azienda ha lasciato che trasmettessero dal vivo, per poi sottrarlo tardivamente.

Rapiscono e torturano un disabile, poi mettono il video su Facebook: arrestati – Repubblica

Usa, torturano giovane disabile psichico e pubblicano video su Facebook – La Stampa

Hanno contribuito a questo articolo Gabriela Mejias e Giustina Vasquez.

Falsobook Falsobook Falsobook Falsobook Falsobook

![]()

Ringraziamo tutti i numerosi lettori di Modus, che con la loro attenzione regolare o sporadica danno senso al nostro lavoro.

A quelli che gradirebbero essere informati sulle nostre pubblicazioni in tempo reale, e hanno un profilo attivo su Facebook, consigliamo di mettere il like sulla fan page: riceveranno senza dover fare l’accesso al sito il link di tutti i nuovi articoli.

La redazione

0 lettori hanno messo "mi piace"